研究内容RESEARCHES

Smart Vision & Robotic Sensing

高速ビジョン・ロボットセンシング

- >> 研究テーマ

- 1秒間に1000コマ以上の実時間画像処理を実現する高速ビジョン技術を始めとして、人間の感覚能力を遥かに上回る実時間センシング技術の確立を目指した情報システム/デバイスの研究開発を行うとともに、高速化・集積化を念頭においたアルゴリズムの研究、さらには人間には感じとることが難しい振動ダイナミクス等の情報を積極的利用した新たなセンシング技術の実現を目指します。

高速3次元検査のための自己投影型コード化パターン光投影法

本研究では、計測環境において高さが大きく異なる対象物が存在する場合においても、同時に高速なデプス計測をすることが可能な自己投影型コード化パターン光投影法によるデプス計測システムを提案する。

本手法では、参照形状により生成される複数の曲線縞パターン光の投影光であるカメラ視野内の複数の直線縞パターン光を処理することにより、3次元の参照形状から異なった形状が求められる。 多くの直線縞パターンによるコード化パターン光投影法と比較し、提案手法を用いることにより曲線縞パターン光の数を減らすことが可能であり、高速処理や3次元形状が背景に存在していた場合の精度低下を抑えた高さの異なった3次元形状の取得が容易となる。 本手法を使用し、高速DLPプロジェクタと同期された高速ビジョンプラットフォームを使用することで、512×512デプス画像を500fpsで実時間取得・処理可能なパターン光投影システムを開発した。 開発したシステムを用いた500fpsでの計測実験を通して、提案手法の有効性を検証した。

本手法では、参照形状により生成される複数の曲線縞パターン光の投影光であるカメラ視野内の複数の直線縞パターン光を処理することにより、3次元の参照形状から異なった形状が求められる。 多くの直線縞パターンによるコード化パターン光投影法と比較し、提案手法を用いることにより曲線縞パターン光の数を減らすことが可能であり、高速処理や3次元形状が背景に存在していた場合の精度低下を抑えた高さの異なった3次元形状の取得が容易となる。 本手法を使用し、高速DLPプロジェクタと同期された高速ビジョンプラットフォームを使用することで、512×512デプス画像を500fpsで実時間取得・処理可能なパターン光投影システムを開発した。 開発したシステムを用いた500fpsでの計測実験を通して、提案手法の有効性を検証した。

|

|

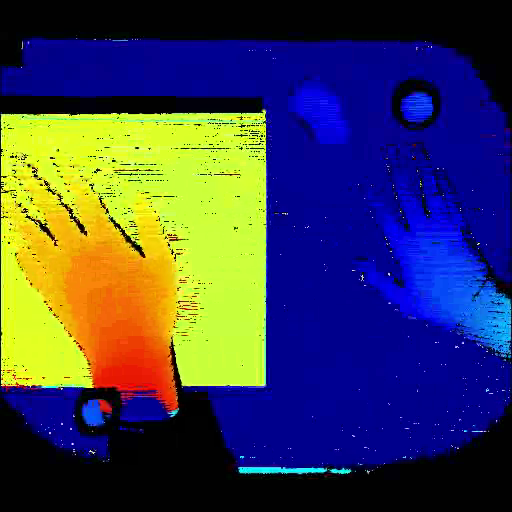

(a) depth video WMV movie(2.6M) |

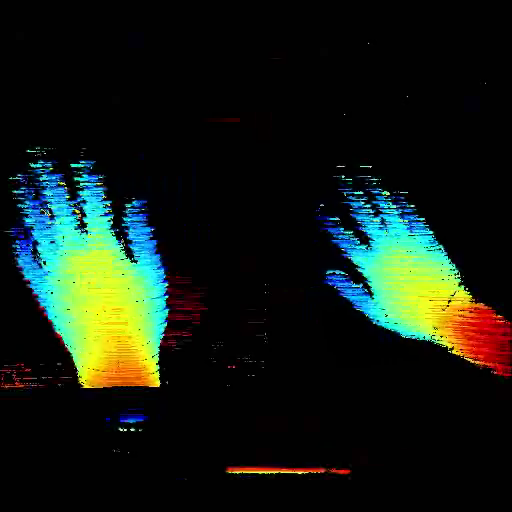

(b) differential depth video WMV movie(2.6M) |

参考文献

- Hao Gao, Tadayoshi Aoyama, Takeshi Takaki, and Idaku Ishii, A Self-projected Structured Light System for Fast Three-dimensional Shape Inspection, International Journal of Robotics and Automation, Vol.30, No.4, 206-4325 (2015)

- Jun Chen, Qingyi Gu, Tadayoshi Aoyama, Takeshi Takaki, and Idaku Ishii, A Fast 3D Shape Scanner Using Two HFR Camera-projector Systems, Proceedings of Advances In Robotics (AIR’15), doi: 10.1145/2783449.2783478, 2015

- Yongjiu Liu, Hao Gao, Qingyi Gu, Tadayoshi Aoyama, Takeshi Takaki, and Idaku Ishii, High-Frame-Rate Structured Light 3-D Vision for Fast Moving Objects, Journal of Robotics and Mechatronics, Vol.26 No.3, pp.311-320 (2014)

- Hao Gao, Tadayoshi Aoyama, Takeshi Takaki, and Idaku Ishii: Self-Projected Structured Light Method for Fast Depth-Based Image Inspection, Proceedings of the International Conference on Quality Control by Artificial Vision, pp.175-180, 2013.